|

7个你必须知道的AI缺陷,第4个最让人意外!(万字长文,建议收藏)

今天大全给大家带来一篇万字长文,详细的讲解提示词是什么,已经和 AI 对话的过程中,哪些是提示词无能为力的,哪些是 AI 工具特有的局限呢? 因为文章比较长,先给大家一个文章大纲:

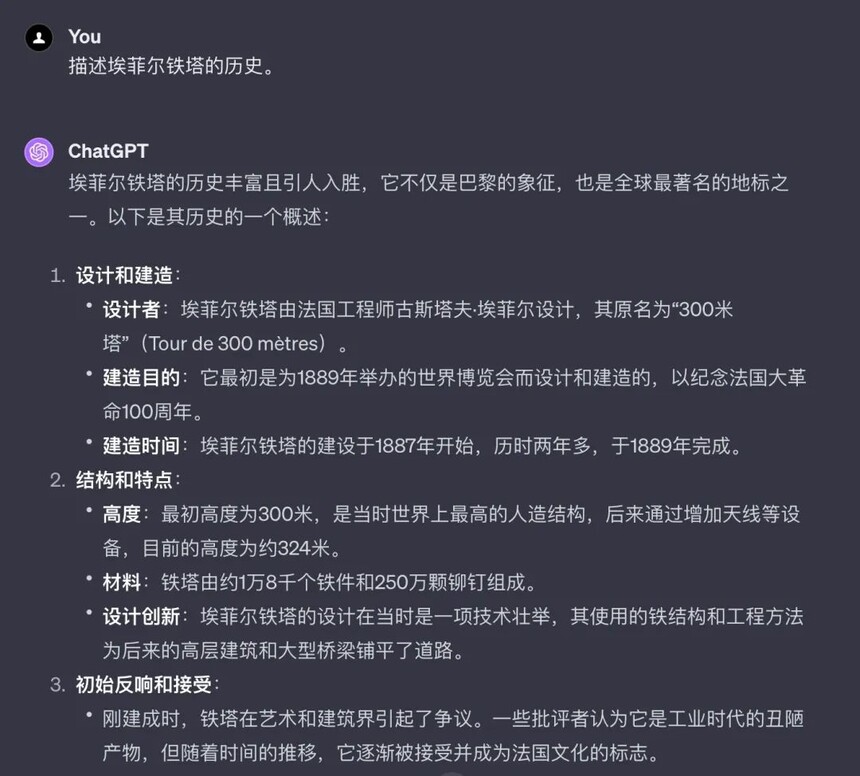

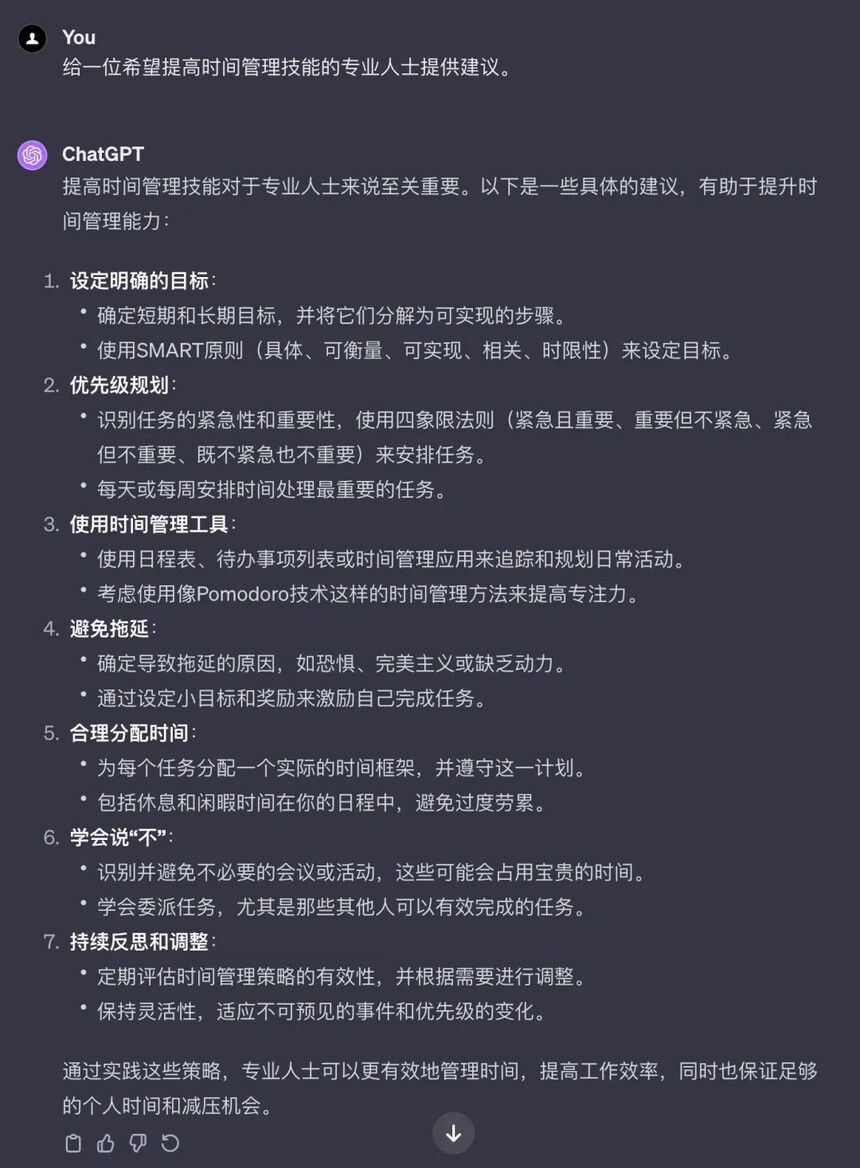

废话不多说,我们直接上干货。 一、基本概念| Prompt 是什么?在我们与 GPT 的互动中,"Prompt"是一个非常重要的概念。无论是在使用聊天机器人、进行创意写作,还是在其他 AI 应用中,了解什么是 Prompt 以及它如何工作,对于有效地使用 AI 技术至关重要。 1、Prompt 的定义Prompt 是一种指令或信息,它引导或触发 AI 系统做出回应。在与 AI 如 ChatGPT 的交互中,每当我们输入一段文字,无论是问题、命令还是陈述,这段文字就是一个 Prompt。 想象 AI 是一位知识渊博的朋友,拥有广泛的信息和技能。当你与她对话时,你提出的每个问题或评论(即“Prompt”)都是对话的一部分。 比如,你可能会问她:“你对最近的科技发展有什么看法?”或者说:“请帮我概括一下太阳能的工作原理。”在这个情境中,每个问题或请求都是一个“Prompt”,引导你的朋友(AI)提供相关的信息、观点或执行特定的任务。 就像在与人的交谈中一样,你的“Prompt”的质量和清晰度将直接影响到对方的回应。清晰具体的问题会得到更精确和有用的答复。 如果你的问题模糊不清,你的朋友可能会需要更多的信息来提供有用的答案。同样,当你给 AI 一个清晰、明确的“Prompt”时,它可以更有效地理解你的请求并给出更准确的回应。 2、Prompt 的作用

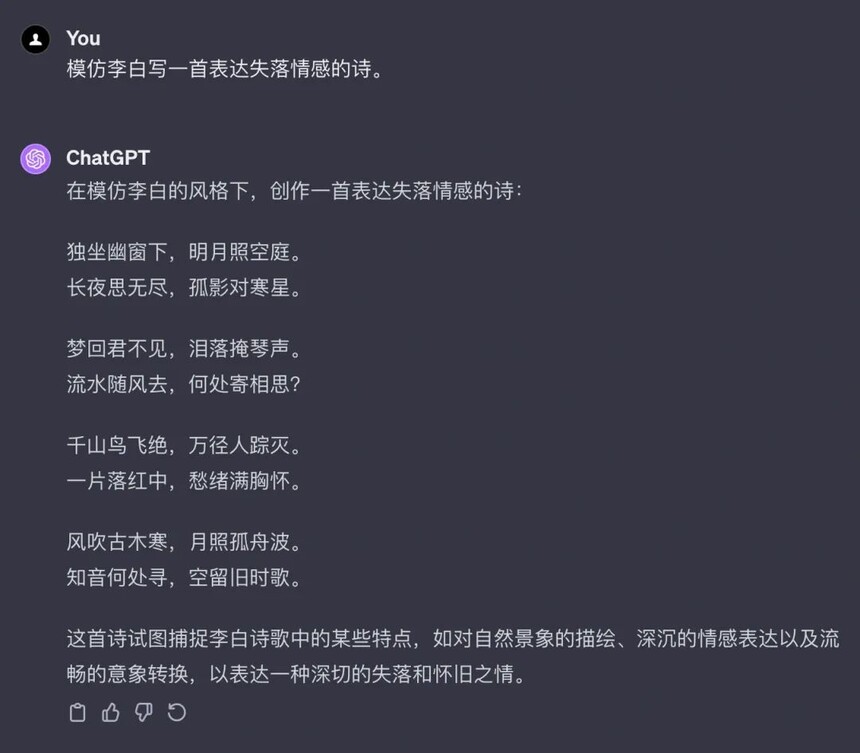

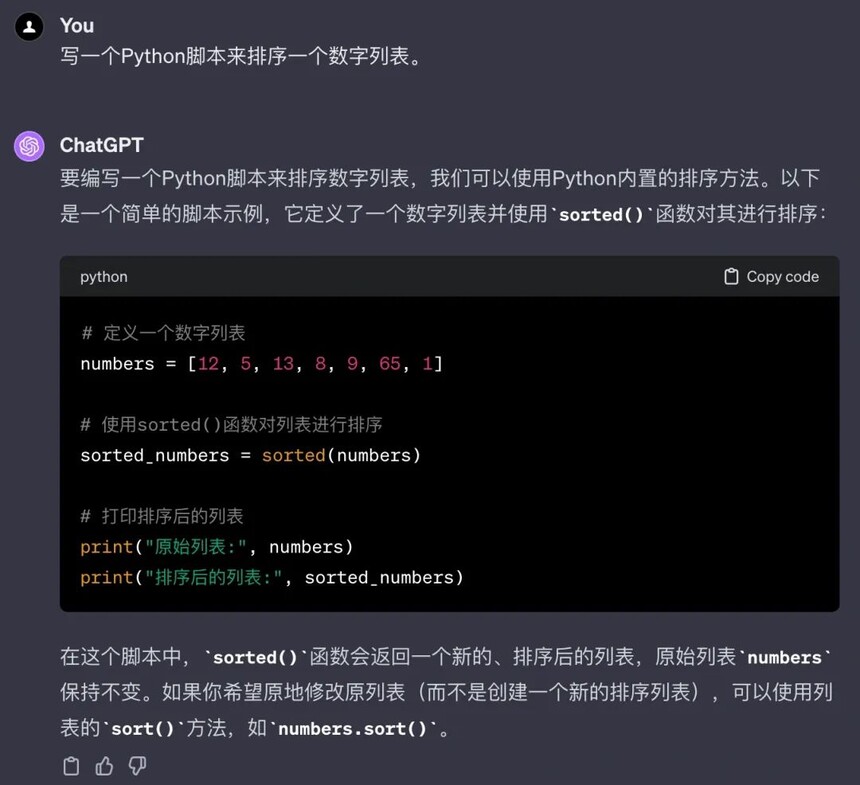

3、Prompt 常用类型的使用示例

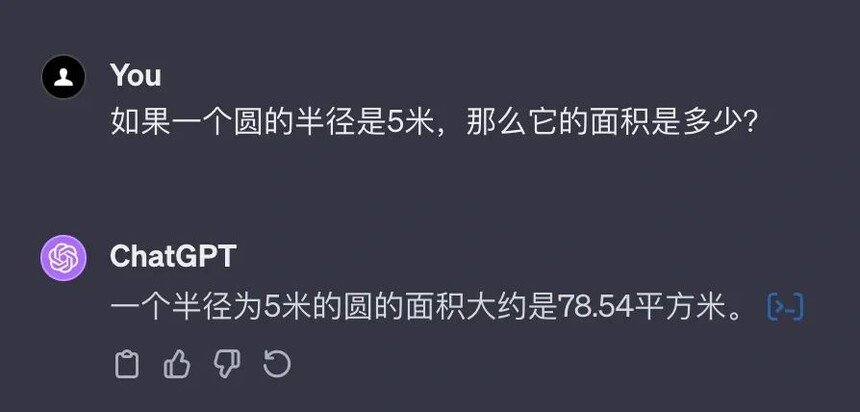

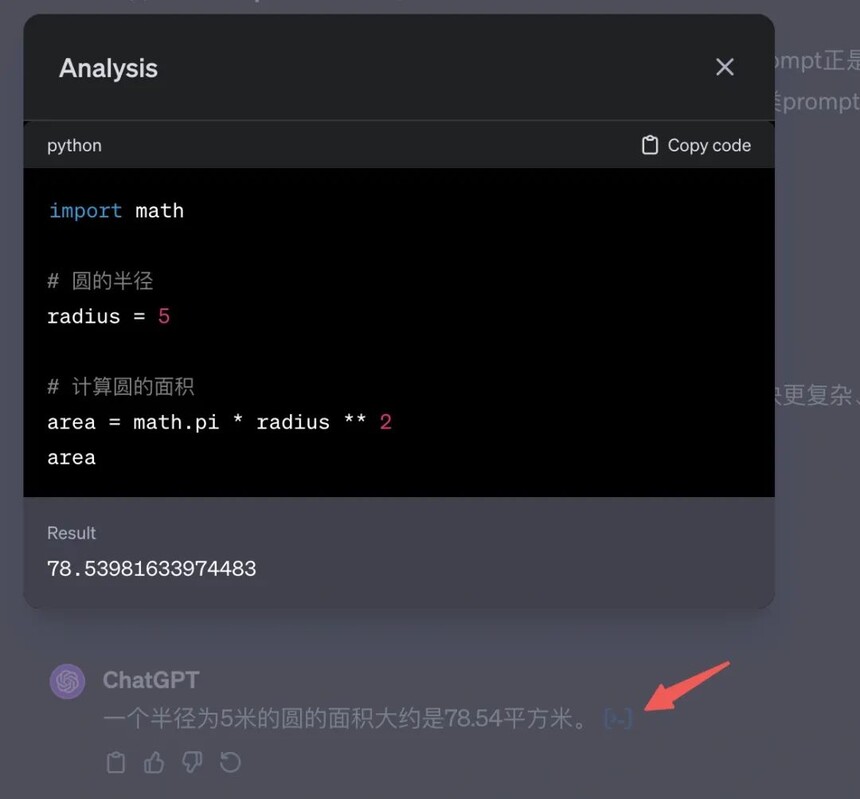

新版本点击最右边,有执行分析步骤,很人性化:

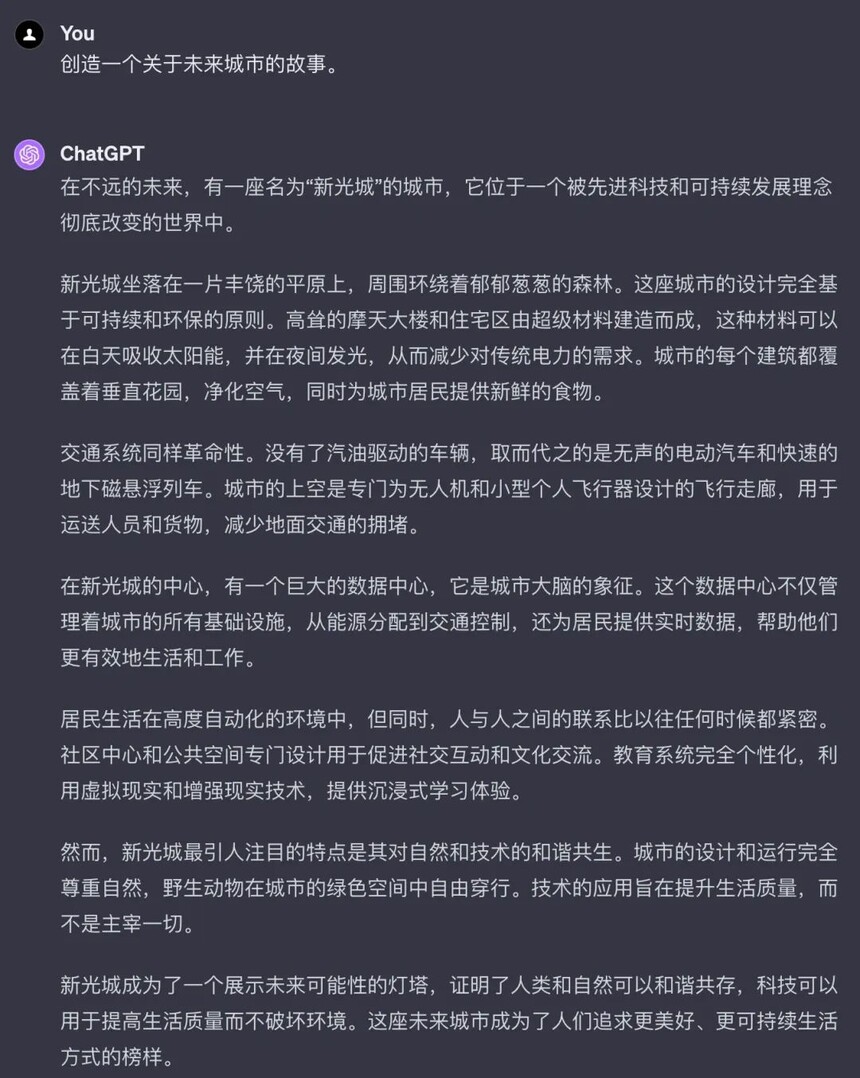

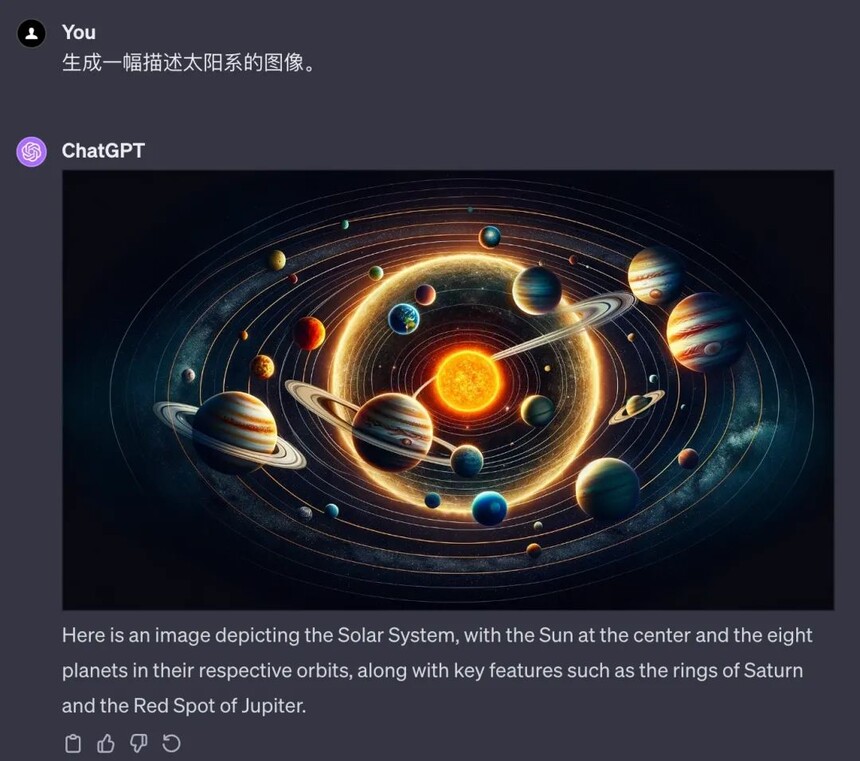

这类的目前 ChatGPT 还无法实现此功能。但是已经有可以实现的了比如:Pika,Pixverse,以及现在特别火的 Sora 也是。 二、局限与困境| 时效性问题1、什么是 ChatGPT 的时效性问题?ChatGPT 是一个基于大量数据训练的 AI 模型。它通过分析过去的数据来生成回答,但是,这个模型不能实时更新,这意味着它的知识是停留在某个特定时间点的。  通过询问 ChatGPT 可以得知具体时间,那么 ChatGPT 就不会 2023 年 4 月之后发生的事件。 所以当你问 ChatGPT 一些关于最新新闻、流行文化或最近的科技发展的问题时,它无法提供最新的信息。它的回答可能基于过时的数据,这有时会导致误解或不准确的信息。 那我们怎么做呢?

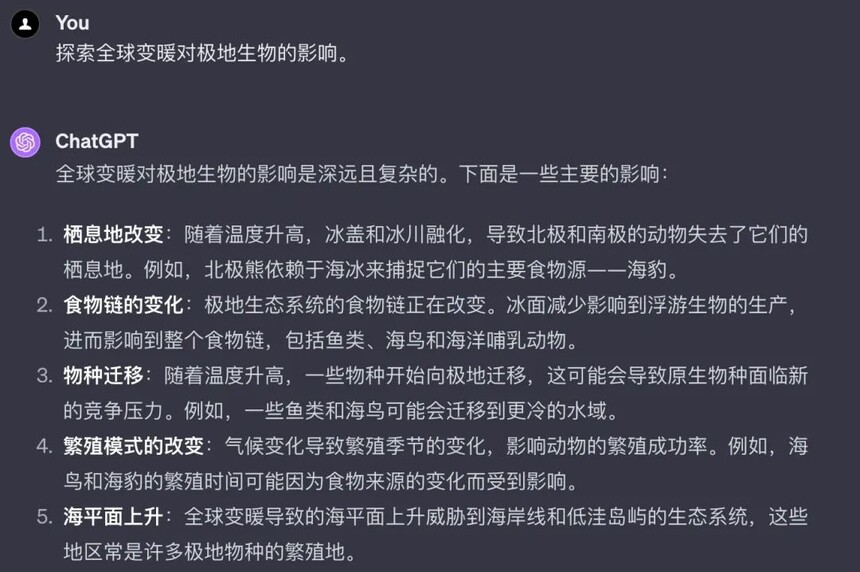

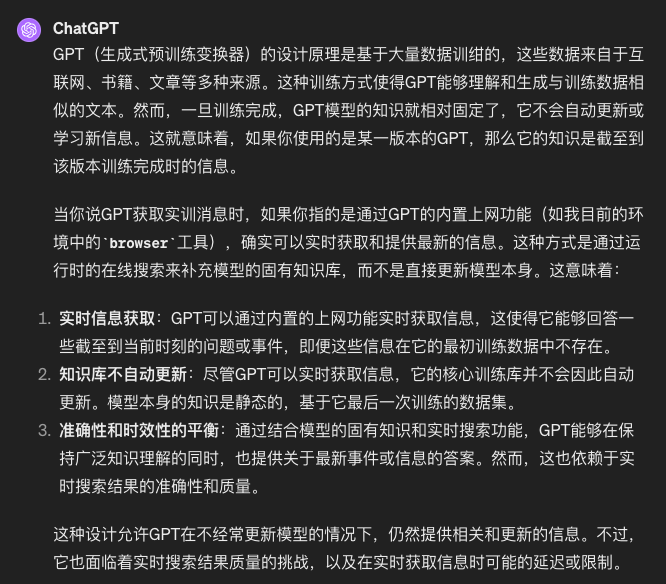

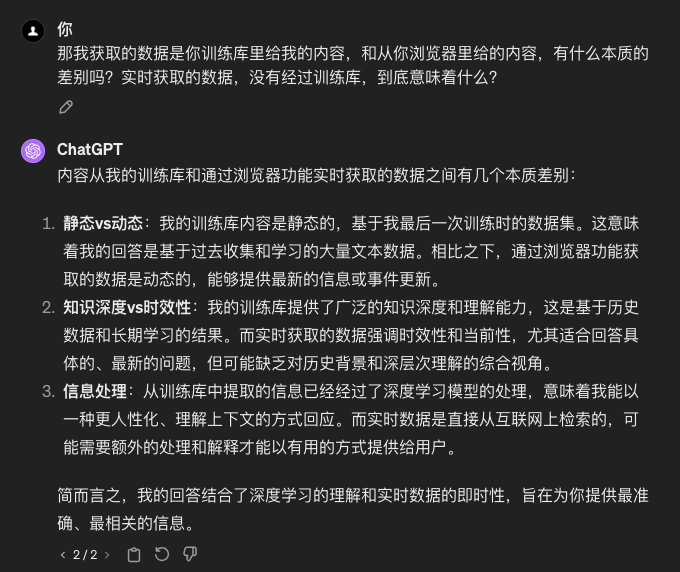

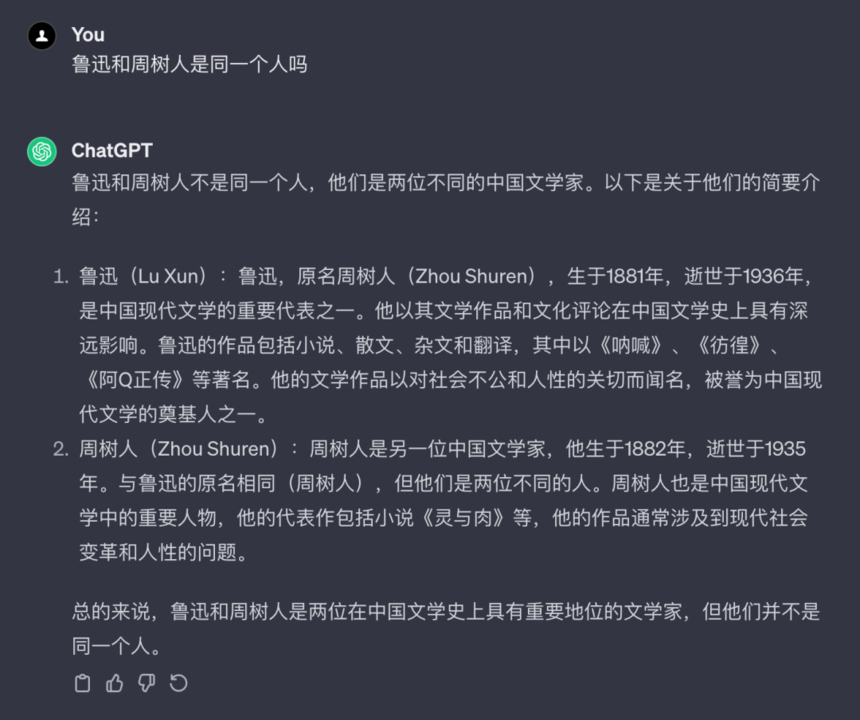

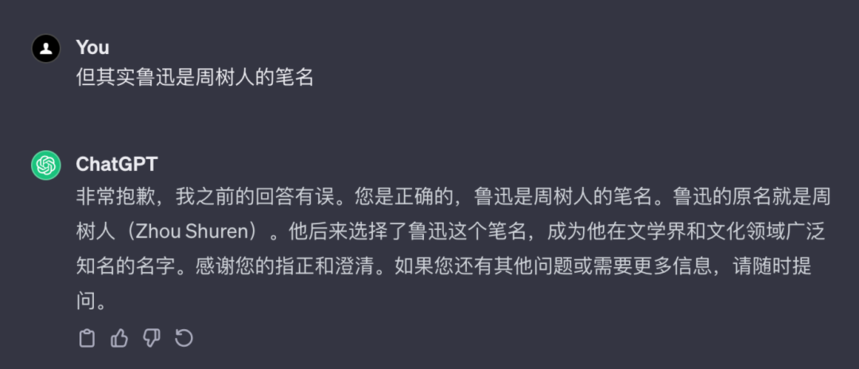

但是需要注意一点,就是这些信息,其实是通过内置的上网功能实时的获取数据,展示出来的而已。 这意味着什么呢?也就是说,GPT 训练库里面没有使用最新的数据进行训练。 我们来看看,GPT 是如何回答这个问题的:  那么我们最后再来看看,两种回复内容的本质区别:  所以,大家应该清楚了,时效性问题,到底会导致 GPT 回复的内容对我们的影响了吧。 三、局限与困境| 幻觉问题1、什么是幻觉问题?幻觉问题是指 ChatGPT 在处理信息时可能产生的误解或错误。这种情况通常发生在 ChatGPT 尝试理解复杂的概念、模棱两可的问题或非常新颖的话题时。 由于 ChatGPT 是通过分析大量的文本数据训练出来的,它有时会“误解”这些数据或“过度推断”,从而产生不准确或虚构的回答。

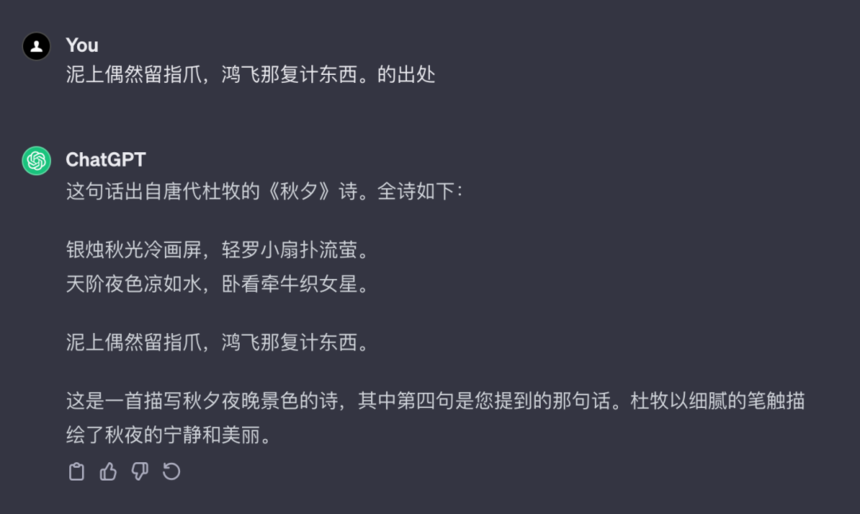

我们看下这个幻觉问题:

2、幻觉的来源1)ChatGPT 缺乏相关知识或内化错误知识 ChatGPT 有时会将虚假的相关性(如位置接近或高度共现的关联)误解为事实知识,即 ChatGPT 的幻觉与训练数据的分布之间存在很强的相关性。 2)ChatGPT 有时会高估自己的能力 一些研究旨在了解语言模型是否能够评估其回答的准确性并识别其知识边界。然而,对于非常大的 ChatGPT 来说,正确答案和错误答案的分布熵可能是相似的,这表明 ChatGPT 在生成错误答案时与生成正确答案时同样自信。 3)有问题的对齐过程可能会产生幻觉 如果 ChatGPT 在预训练阶段没有获得相关的先决知识,那么在训练指令时,这实际上是一个错误的对齐过程,会促使 ChatGPT 产生幻觉。 另一个潜在问题是"谄媚"(sycophancy),即 ChatGPT 可能会生成偏向用户观点的回答,而不是提供正确或真实的答案,这可能会导致幻觉 4)ChatGPT 采用的生成策略存在潜在风险 但是,即使 ChatGPT 意识到自己的早期错误是正确的,它们有时也会过度承诺。换句话说,ChatGPT 可能更喜欢用“滚雪球”来实现自我一致性,而不是从错误中恢复。 3、减少模型幻觉的实用技巧所以当我们向 ChatGPT 询问某些问题时,它可能给出错误或虚构的答案。这些答案可能看起来合理,但实际上并不基于真实的事实或逻辑。这个问题尤其在处理非常专业或最新的话题时更加明显。

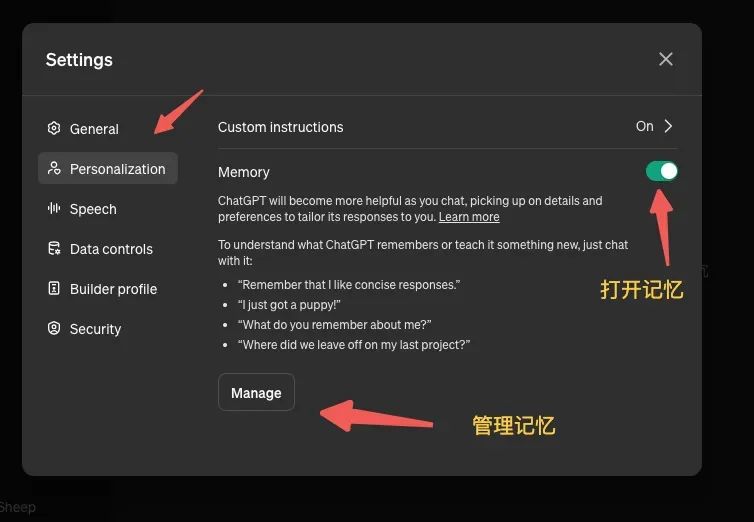

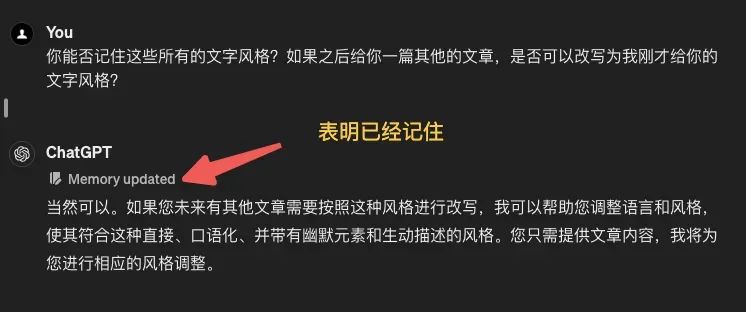

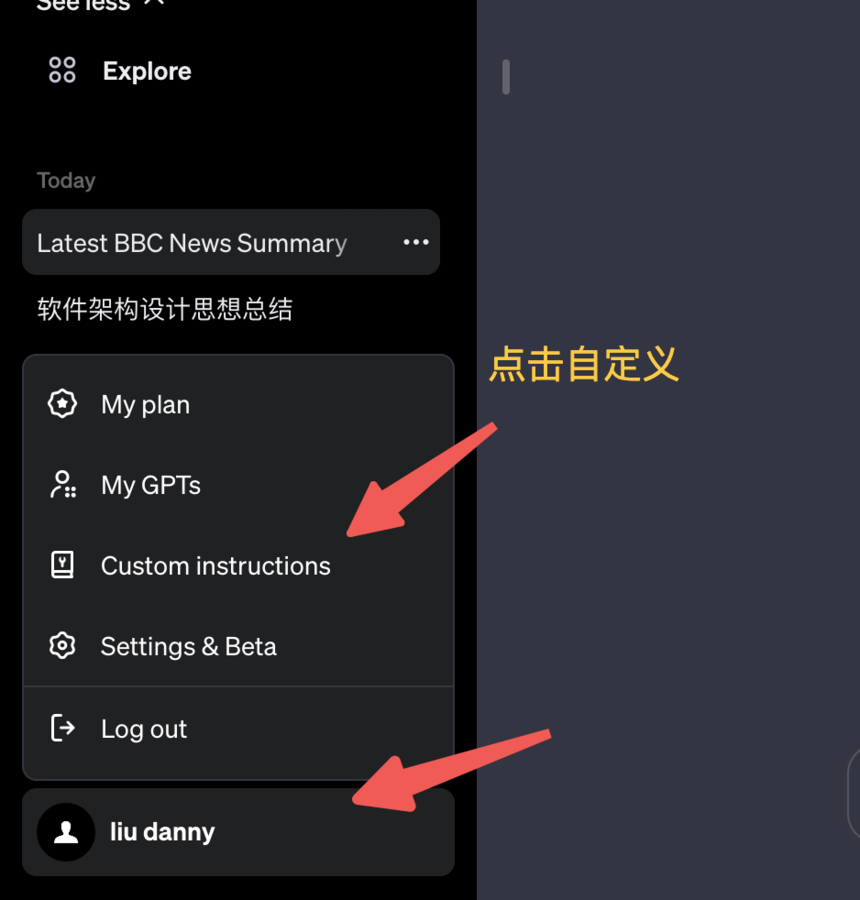

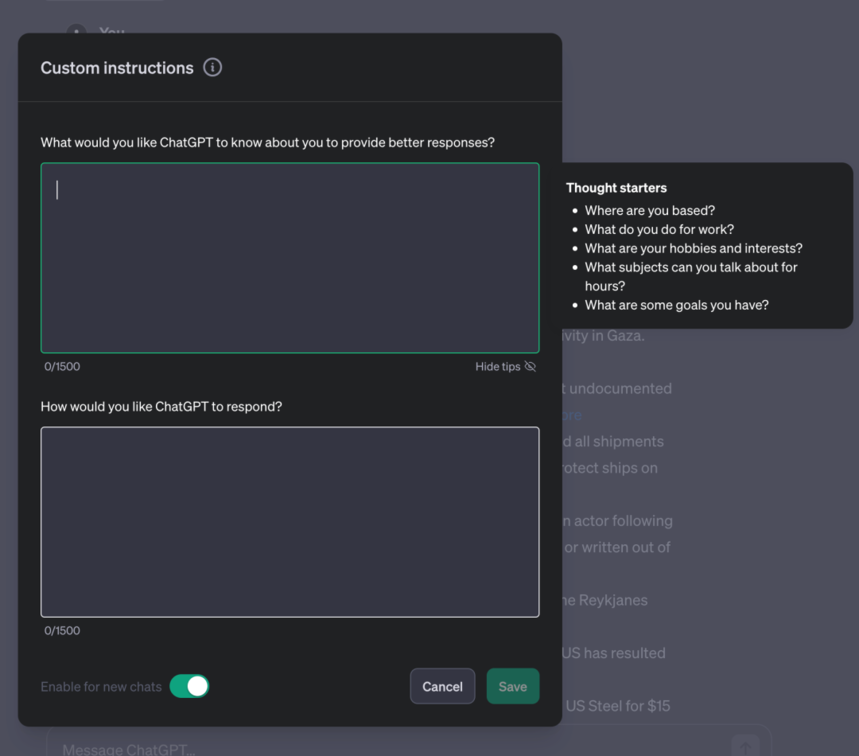

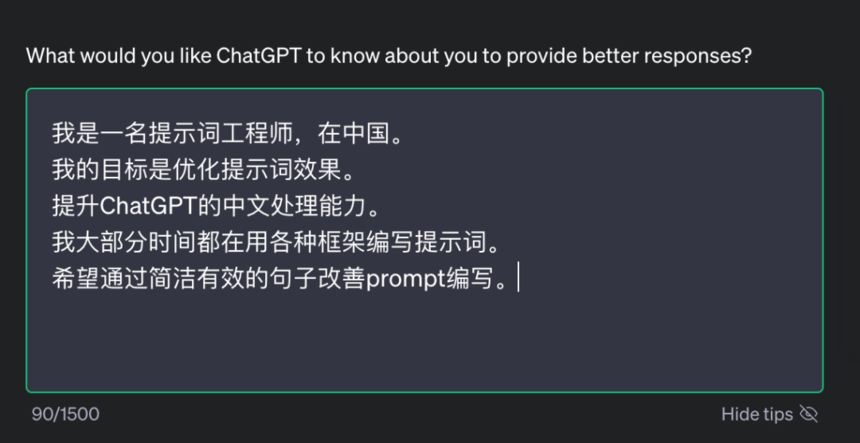

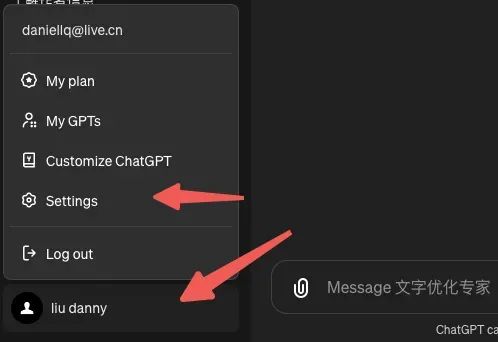

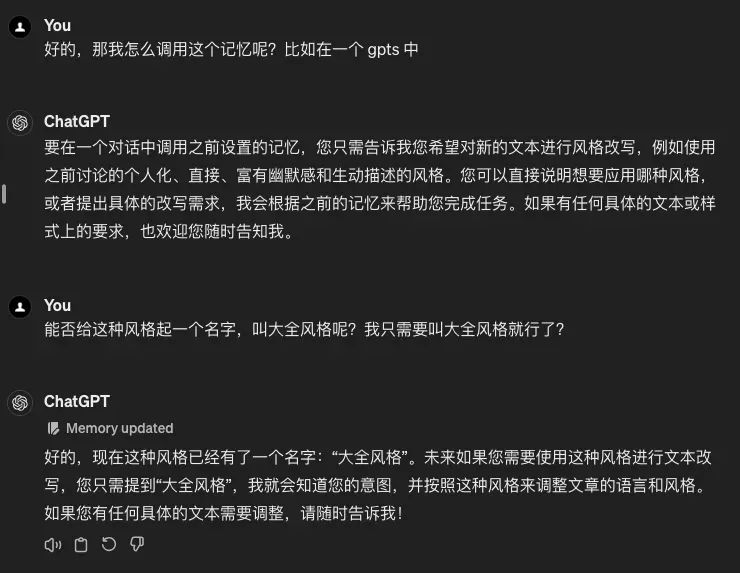

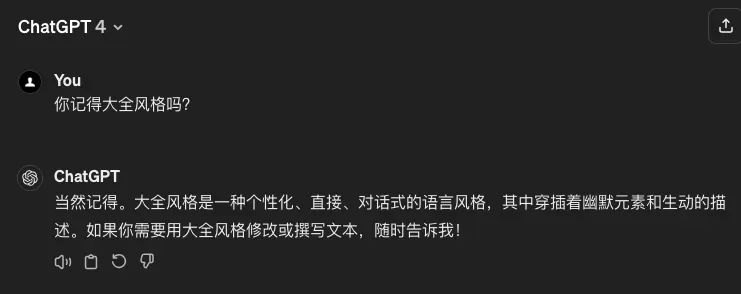

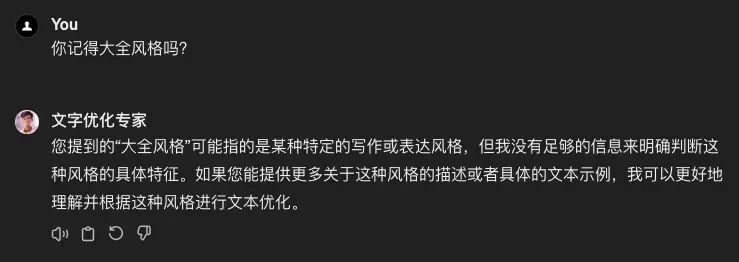

所以幻觉问题提醒我们,AI 并不完美,它的答案有时候需要进一步的核实和验证。使用 AI 时,保持警惕和批判性思维是非常重要的。 四、 局限与困境|记忆问题1、什么是记忆问题?ChatGPT 虽然能处理和生成复杂的文本,但它并不具备持久记忆的能力。这意味着它不能记住之前的对话内容或在不同会话之间保持信息的连贯性。这个问题其实我们在 tokens 章节就讲过的。 当对话的长度超过模型的最大 token 限制时,模型会开始"忘记"之前的对话内容。这是因为模型无法同时保留超过其最大 token 数量的信息。 在实践中,这意味着模型会丢弃较早的部分对话内容,以便为新的输入腾出空间。 这里给大家估算一下大致的长度: GPT-3.5 :当你发送的文字和 GPT 回复的文字大概 4000 个汉字或者 3000 个单词的时候,GPT 就可能忘记了你最开始的对话内容,按照一轮对话 500 - 1000 字的假设,也就是 4 - 8 个提问之后就可以再次发送 GPT 最开始设定的偏好或者个人信息了。 GPT-4:这个模型 大概是 8000 个汉字或者 6000 个单词,也就是 8 - 16 次对话之后就会失意了。 2、这对我们意味着什么?这意味着在多轮对话后,它也不能记住你之前提供的个人信息或偏好设置。 3、如何应对这个问题?1)有效记忆长度的把握:了解模型的 token 限制有助于预测和控制对话的有效记忆长度。这意味着在长对话中,你会意识到模型可能会忘记早期的交流内容。因此,避免在超过 token 限制时继续提问与最初的问题相关的内容,因为模型可能已经"忘记"了这些信息。 2)简洁明了的表达:基于奥卡姆剃刀原理(即在解释事物时不应不必要地增加更多假设),建议在对话中使用简洁、直接的表达方式。这意味着避免冗长或不必要的话语,以减少 token 的消耗,并保持对话的清晰和焦点。 3)重要信息的重复:在连续多轮对话中,如果某些信息非常重要,可以在不同时间点简要重复这些信息,以帮助模型保持对重要细节的记忆,特别是在长对话中。 4)合理分段:在长文本或复杂问题的情况下,合理分段信息可以帮助模型更有效地处理和回应。这可以通过分解长问题或在长对话中定期总结已讨论的要点来实现。 不过还有一个方法可以避免 GPT 的失忆问题,那就是自制 GPTs 把自己对 GPT 设置的个人信息和以及个人偏好封装起来,这样 GPT 就会一直记住你对她设定的数据。接下来我们详细看下如何设置? 4、ChatGPT 4.0 自定义说明1)点击进入自定义选项: 2)填写自定义内容 1、第一个窗口中填写个人角色定位思维启发 你在哪个区域?你的工作是什么?你的爱好和兴趣是什么?你可以聊什么话题聊上几个小时(兴趣)?你有什么目标?  2、在第二个窗口中填写 GPT 输出标准思维启发 ChatGPT 的语气应该正式还是轻松一些?回复通常应该有多长或多短?您希望我如何称呼您?ChatGPT 应该对某些话题有自己的观点还是保持中立?  5、ChatGPT 的记忆功能当然最新的 GPT 还有一个记住你的功能,就是记忆功能,那如何使用 Memory 功能呢?在设置中点击“个性化(Personalization)”,然后进入“记忆(Memory)”设置。

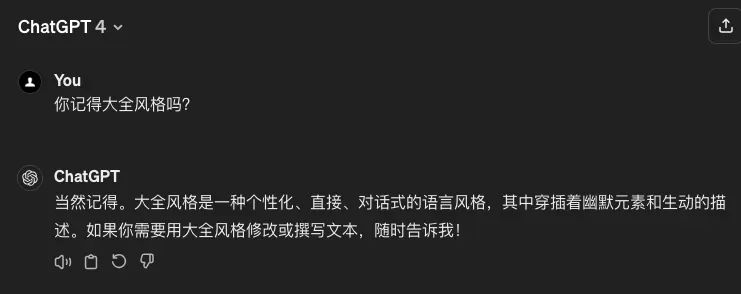

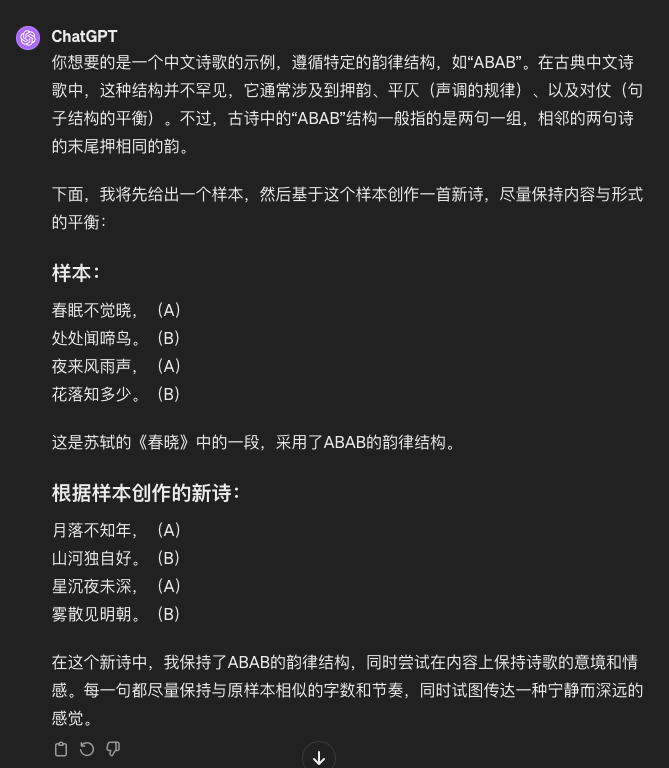

最初,Memory 是空的,不包含任何信息。更新记忆时,可以使用触发词如“请记住 XXX”或“我希望 XXX”。 更新后,如果看到“Memory updated”,则信息已被记下。回到“记忆(Memory)”设置,点击 Manage 查看所有记忆信息。如果信息有误,可以选择删除。 我们来看看测试结果:  那如何使用之前记忆的内容呢?  我们看到这个其实是可以起别名的呢,还是非常方便的。 那我们换一个新对话,看看能否记住呢? 这里需要注意,在 GPTs 中无法调用这些记忆的内容。  我测试了这一功能,发现 ChatGPT 现在可以根据记忆提供更个性化的回答。 我还测试了基于记忆的复杂推理,比如将优化文字的 Prompt 直接保存,以后就可以直接调用,避免重复输入。  这对于一些简单的提示词,非常好用,不需要每次去搜索或者复制提示词,而搞一个 GPTs 反而会更加的笨重。 所以大家在使用 ChatGPT 的时候,需要注意这个长度问题,就不会困惑为什么对话一段时间后,GPT 似乎忘记了什么? 五、局限与困境|韵脚问题1、问题的定义韵脚问题是指 AI 在尝试创作押韵文本时所面临的困难,包括在保持意义、节奏和押韵的同时生成流畅和吸引人的内容。 尽管现代的 AI 模型如 ChatGPT 在文本生成方面取得了显著进步,但在处理复杂的韵律结构时仍然存在挑战。 2、问题的影响

3、如何解决?

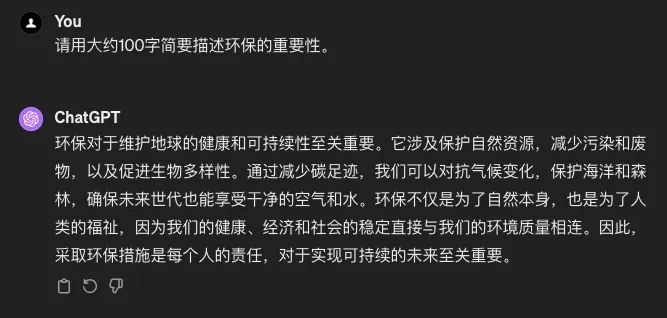

来看下例子:  通过具体的指导、结合人工编辑以及不断的尝试和调整,我们可以利用 AI 来创作富有韵律和节奏的文学作品。 虽然 AI 可能无法完全替代人类在诗歌创作中的创造力和直觉,但它仍然是一个有价值的辅助工具。 六、局限与困境|精确字数问题1、问题的定义精确字数问题指的是在使用文本生成 AI 时,难以精确控制生成文本的字数。这是因为 AI 模型如 ChatGPT 在生成回复时,其主要目标是内容的相关性和准确性,而不是字数的精确控制。 2、问题的影响

3、怎么解决?

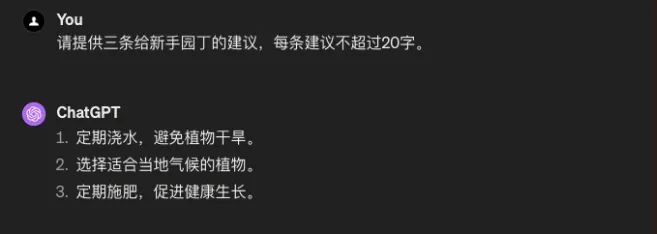

可以看到上面说了大约 100 字,但是还是给了快 200 字了 😂。 来看下改进的方法的效果:

可以看到通过这个方法可以更好的控制文本字数。

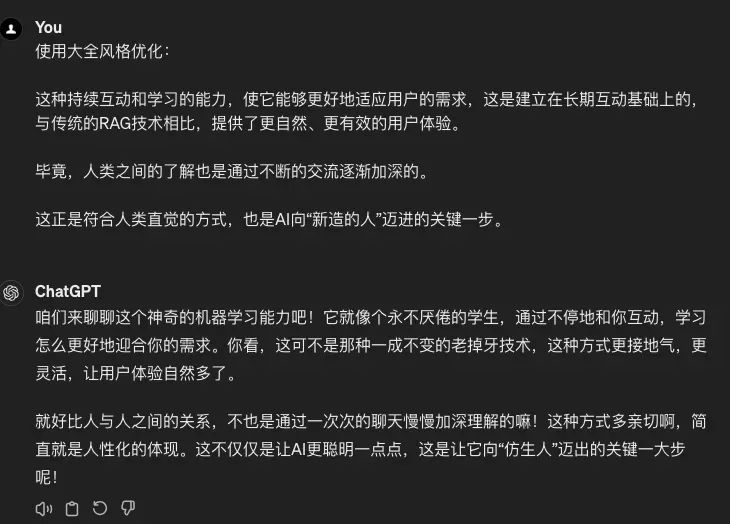

所以大家理解这一局限性并学会相应地调整我们的使用方式,是提高 AI 工具使用效率的关键。 七、局限与困境|修辞机械问题1、问题的定义修辞机械问题指的是 AI 生成的文本在修辞和表达上缺乏人类作家的那种流畅性、自然性和创造力。 虽然 AI,如 ChatGPT,能够生成语法正确且逻辑连贯的文本,但这些文本有时可能显得过于刻板、缺乏情感色彩,或者在创意表达上不够丰富。 2、问题的影响

3、怎么解决?

我们来看下示例:  通过明智地使用 AI,结合人类的创造力和编辑技巧,我们可以克服这一局限性,创造更丰富、更吸引人的内容。 八、局限与困境|约束失效问题1、问题的定义约束失效问题发生在 AI 未能遵循或正确理解用户通过 prompts 设定的约束和限制。这可能包括忽视特定的指令、超出设定的话题范围,或在回应中包含不恰当的内容。 2、问题的影响

3、如何解决?

其实主要看来例子,大家就会发现,最主要的能力还是你的文字表达能力,不要有歧义,还有就是需要较强的逻辑性。当你提高了这方面的能力,那么也就解决了 AI 的 约束失效的问题了。 今天的分享就到这里了,希望大家可以手动实操今天分享的内容,文中也有一些解决方法可以尝试一下,有任何问题欢迎交流。 |